Experimente sind fester Bestandteil pädagogisch-psychologischer Forschung. Manche davon erhalten als “Klassiker” hohe Aufmerksamkeit und Verbreitung. Sie werden dann häufig zitiert, aber selten im Original gelesen. Als Folge werden die Ergebnisse möglicherweise fehlinterpretiert oder in ihrer Aussagekraft überbewertet. Wir haben uns auf die Spurensuche nach vier oft zitierten Studien begeben, deren Effekte im Lehr-Lernkontext häufig als gesichert gelten.

Dr.-Fox-Effekt

Mit einem Experiment aus den 1970er Jahren untersuchten Naftulin et al. (1973), wie die Bewertung einer Vorlesung durch den Vortragsstil beeinflusst wird. Dazu schlüpfte ein professioneller Schauspieler in die Rolle von Dr. Fox, einem angeblich renommierten Wissenschaftler. Er hielt eine charismatisch vorgetragene Vorlesung, die inhaltlich aber voller widersprüchlicher Aussagen, Fehlschlüsse und sinnloser Verweise war.

Die Zuhörer:innen bewerteten den Vortrag ausgesprochen positiv und gaben an, er hätte sie zum Nachdenken angeregt. Die Autoren deuteten dies als Beleg, dass der Vortragsstil die subjektive Zufriedenheit mit Lehrveranstaltungen von Studierenden stärker beeinflusst als der Inhalt. Studierende können mit Autorität und Witz wirksam zu einer Illusion des Lernens verführt werden.

Diese Erkenntnis wurde als Dr.-Fox-Effekt bekannt. Dabei wird sie häufig als Beleg herangezogen, dass studentische Evaluation nicht valide die Qualität von Lehrveranstaltungen (verstanden als Förderung des Lernens) erfasst.

Wie so häufig, ist die Lage aber nicht so eindeutig. In einer Replikationsstudie überprüften Ware & Williams (1975) nicht nur die Zufriedenheit von Studierenden, sondern auch deren Lernerfolg. Diesmal hielt Dr. Fox sechs Vorlesungen. Sie unterschieden sich in ihrem inhaltlichen Gehalt (hoch, mittel und niedrig) und wurden jeweils in einer unterhaltsamen und einer nüchternen Version gehalten. Wie bei der Originalstudie bewerteten Studierende die anregend gehaltenen Vorlesungen besser als die nüchternen Vorträge. Überraschend war aber, dass Studierende bei vergleichbarem inhaltlichem Niveau auch im Wissenstest bei der anregenden Vorlesung besser abschnitten.

Peer & Babad (2014) konnten die Effekte der ursprünglichen Studie (Naftulin et al., 1973) 40 Jahre später nochmals replizieren: Die Studierenden bewerteten auch unter Berücksichtigung variierender Versuchsbedingungen (z.B. Vorwissen, vermeintlicher Status des Redners) den weitgehend inhaltsleeren, aber anregenden Vortrag des Dr. Fox durchwegs positiv. Ergänzend fragten Peer & Babad (2014) die Probanden nach dem subjektiven Lerneffekt. Hier zeigte sich: Nur rund ein Drittel der Teilnehmer:innen gaben an, sie hätten in der Vorlesung etwas gelernt.

Was zeigen diese Studien? Der Dr.-Fox-Effekt ist keine reine Illusion. Studierende können einerseits von einem unterhaltsamen Vortragsstil profitieren und andererseits durchaus einschätzen, ob sie etwas gelernt haben. Die Frage nach der Validität von Lehrveranstaltungsevaluationen kann mit dem Dr.-Fox-Effekt daher nicht eindeutig geklärt werden.

Uncanny-Valley-Effekt

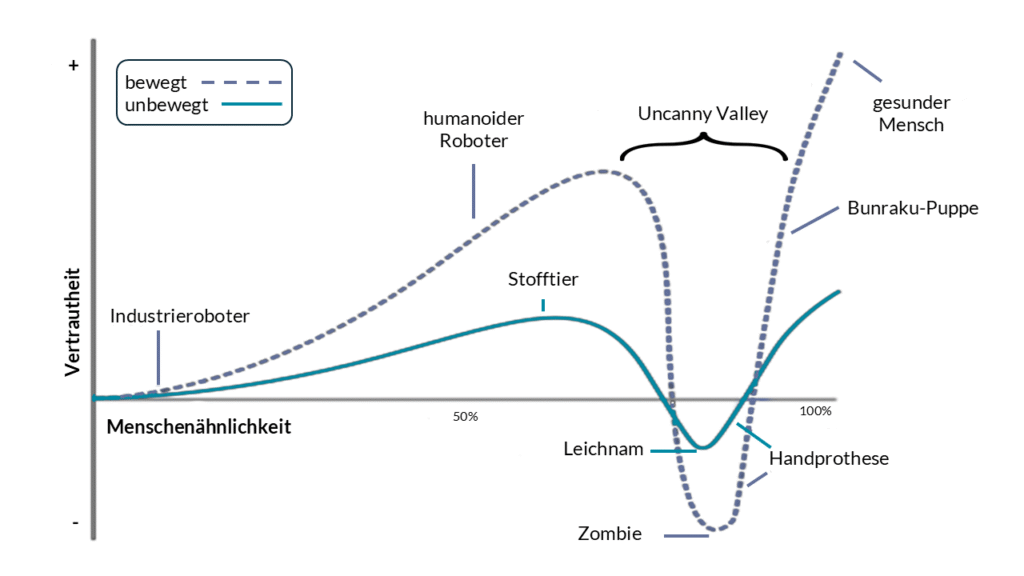

Masahiro Mori, Professor für Robotik, prägte 1970 den Begriff des Uncanny-Valley-Effekts. Er beschreibt damit das Phänomen, dass künstliche Agenten, z.B. Roboter, Avatare oder synthetische Stimmen, ein Gefühl des Unbehagens auslösen können, wenn sie zwar fast, aber nicht vollständig menschlich wirken. Mori skizzierte eine nichtlineare Kurve der Vertrautheit in Abhängigkeit von der Menschenähnlichkeit (vgl. Abbildung 1): Mit zunehmender Ähnlichkeit steigt die Vertrautheit zunächst kontinuierlich an, erreicht jedoch kurz vor der vollkommenen Menschenähnlichkeit einen kritischen Punkt, an dem selbst geringfügige Abweichungen, z.B. eine täuschend echt aussehende Handprothese, die beim Händedruck kalt erscheint, als besonders unheimlich empfunden werden (das “unheimliche Tal“). Mori vermutete zudem, dass Bewegung diesen Effekt noch verstärken kann (Mori, MacDorman & Kageki, 2012).

Quelle: Smeltzer (2009), Mori Uncanny Valley de, [Grafik], Wikimedia Commons, CC BY-SA 3.0, https://commons.wikimedia.org/wiki/File:Mori_Uncanny_Valley_de.svg; bearbeitet von lehrblick.de.

Diel et al. (2021) konnten in ihrer Metaanalyse von 72 Einzelstudien die Existenz des Uncanny-Valley-Effekts bestätigen (Hedges’ g = 1.01). Das Auftreten des Effekts ist jedoch nicht allgemeingültig, sondern an spezifische Bedingungen gebunden: Besonders starkes Unbehagen entsteht durch inkonsistente Hinweisreize – etwa wenn eine künstlich wirkende Hauttextur mit hochrealistischen, lebendig erscheinenden Augen kombiniert wird („perceptual mismatch“; Kätsyri et al., 2015).

Die quantitative Bestätigung des Effekts und die empirisch belegte Bedeutung des perceptual mismatch liefern praktische Hinweise, u.a. für die Gestaltung virtueller Charaktere, wie sie z.B. auch in Online-Lernumgebungen eingesetzt werden. Mit Hilfe von KI lassen sich heute schnell und unkompliziert menschenähnliche Avatare und fotorealistische Darstellungen erzeugen – allerdings besteht dabei die Gefahr der Inkonsistenz. Statt also eine riskante, nahezu perfekte Menschenähnlichkeit anzustreben, erweist sich ein bewusst stilisierter, nicht-hyperrealistischer Ansatz häufig als sicherer und führt zu höherer Akzeptanz.

Testungseffekt

Der Testungseffekt (auch „Testing Effect“ oder „test-enhanced learning“ genannt) beschreibt die Besonderheit, dass das aktive Abrufen von Wissen das langfristige Behalten von Lerninhalten deutlich besser fördert als wiederholtes Durchlesen oder bloßes Wiederholen der Informationen. Sowohl das Testformat als auch der Zeitpunkt der Tests beeinflussen, wie stark der Effekt wirkt (Rummer & Schweppe, 2022). Dozierende können für Lernende verschiedene Arten von Tests bereitstellen, darunter zum Beispiel Matching-Aufgaben, Lückentext, Kurzantworten, Multiple-Choice-Tests, freie Wiedergabe, das Erstellen von Mindmaps oder kurze Essays.

Rowland (2014) zeigte in einer Metastudie, dass Testformate unterschiedlich stark wirken. Freie Wiedergabe fördert das Lernen mehr als Erkennungstests. Feedback nach einem Test steigert den Lernerfolg zudem deutlich. Das bedeutet, es lohnt sich, über mögliche Feedbackoptionen nachzudenken, um Studierende in ihrem Lernprozess zu unterstützen. Auch der Zeitpunkt eines Tests beeinflusst den Lernerfolg. Längere Zeitintervalle zwischen Lernen und Testung verstärken den Effekt. Jedoch führen selbst kurze Abstände zu positiven Ergebnissen.

Laut der Metastudie von Yang et al. (2021) steigern mehrere Tests den Lernerfolg. Der Testungseffekt ist dabei universell anwendbar. Er wirkt in allen Bildungsstufen, von der Grundschule bis zur Hochschule. Außerdem hängt dieser weder vom Alter noch vom Geschlecht ab. Regelmäßige Tests bilden daher einen zentralen Baustein für nachhaltiges Lernen.

Und wenn es mit dem Test mal nicht so gut läuft?

Kein Problem: Vergessen hilft beim Erinnern. Wer sich selbst testet und Fehler macht, lernt besser als jemand, der nur wiederholt. Der Lernschub entsteht nicht durch den Test, sondern durch das aktive Abrufen. Schon der Versuch, sich an Wissen zu erinnern, stärkt das Gedächtnis. Selbst wenn dabei Fehler passieren.

Dunning-Kruger-Effekt

David Dunning und Justin Kruger untersuchten in Experimenten die Selbsteinschätzung eigener Kompetenzen in verschiedenen sozialen und intellektuellen Bereichen (Kruger & Dunning, 1999). In Tests zu Humor, Grammatik und Logik wurde der Wissensstand gemessen. Anschließend bewerteten die Untersuchungsteilnehmenden ihre eigene Leistung, ohne das tatsächliche Ergebnis zu kennen. Es zeigte sich, dass Personen, die schlecht abschnitten, die eigenen Fähigkeiten übermäßig positiv bewerten. Die Autoren kamen zu dem Ergebnis, dass Personen, die in einem Gebiet nur geringe Kompetenzen haben, dazu tendieren, eigene Fähigkeiten zu überschätzen (Dunning-Kruger-Effekt). Dunning und Kruger vermuten das Problem in den metakognitiven Fähigkeiten der Teilnehmenden. Inkompetente Personen besitzen meist nicht das notwendige Wissen, um eigene Fehler oder Wissenslücken zu erkennen (Dunning, 2011). Ähnlich einer KI scheinen sie zu „halluzinieren“, wenn sie in einem Thema nicht auf eine Wissensbasis zurückgreifen können. Mit steigendem Wissen und Erfahrung verbessert sich die Selbsteinschätzung dieser Personen allerdings (Kruger & Dunning, 1999) und sie erkennen wie Sokrates: „Ich weiß, dass ich nichts weiß“.

Kritiker des Dunning-Kruger-Effekts merken allerdings an, dass die Ergebnisse durch das statistische Design der Studie hervorgerufen wurden und der Effekt mit zufällig generierten Daten erzeugt werden kann (Nuhfer et al., 2016). Außerdem werden keine weiteren Variablen wie Persönlichkeitsmerkmale oder kulturelle Einflüsse berücksichtigt.

Nichtsdestotrotz sollten die Ansichten von Dunning und Kruger Dozierende dazu ermutigen, die Fähigkeiten ihrer Studierenden zur Selbstreflexion und Metakognition zu fördern. So können Studierende erkennen, was sie noch nicht wissen (Selbstreflexion) und sind in der Lage, diese Wissenslücken zu schließen (Metakognition). Im Sinne des formativen Assessments sollten Dozierende ihren Studierenden viele verschiedene Aufgaben stellen. Dadurch erhalten diese die Möglichkeit, die eigenen Kompetenzen stetig zu überprüfen. Direkt im Anschluss sollten die Dozierenden ein Feedback geben, das einerseits auf Wissenslücken hinweist und andererseits die Studierenden dazu anregt, darüber nachzudenken, was sie konkret tun können, um diese Lücken zu füllen. Dadurch werden die metakognitiven Fähigkeiten der Studierenden gefördert. Zusätzlich sollte immer wieder auch die Selbsteinschätzung eigener Leistungen ermöglicht werden, sodass eine realistische Selbstreflexion möglich ist.

Fazit

Die vier beschriebenen Effekte zeigen: Es lohnt sich, landläufige Annahmen zum Lehren und Lernen zu hinterfragen und Studienergebnisse differenziert zu betrachten. Denn auch „Klassiker“ können sich als Mythen herausstellen.

Kennen Sie weitere Effekte, die einem Faktencheck unterzogen werden sollten? Schreiben Sie uns, am besten per E-Mail oder auf LinkedIn. Wir prüfen diese dann im Rahmen eines kommenden Blogbeitrags.

Literatur

Diel, A., Weigelt, S., & MacDorman, K. F. (2021). A Meta-analysis of the Uncanny Valley’s Independent and Dependent Variables. ACM Transactions on Human-Robot Interaction, 11(1), 1–33. https://doi.org/10.1145/3470742

Dunning, D. (2011). Chapter five – The Dunning–Kruger Effect: On Being Ignorant of One’s Own Ignorance. Advances in Experimental Social Psychology, 44, 247-296. https://doi.org/10.1016/B978-0-12-385522-0.00005-6

Kätsyri, J., Förger, K., Mäkäräinen, M., & Takala, T. (2015). A Review of Empirical Evidence on Different Uncanny Valley Hypotheses: Support for Perceptual Mismatch as One Road to the Valley of Eeriness. Frontiers in Psychology, 6, Article 390. https://doi.org/10.3389/fpsyg.2015.00390

Kruger, J. & Dunning, D. (1999). Unskilled and unaware of it: how difficulties in recognizing one’s own incompetence lead to inflated self-assessments. Journal of personality and social psychology, 77 (6), 1121- 1134. 10.1037/0022-3514.77.6.1121

Mori, M., MacDorman, K. F., & Kageki, N. (2012). The uncanny valley [Authorised reprint]. IEEE Robotics & Automation Magazine, 19(2), 98–100. https://doi.org/10.1109/MRA.2012.2192811

Naftulin, D. H., Ware Jr., J. E., & Donnelly, F. A. (1973). The Doctor Fox Lecture: A Paradigm of Educational Seduction. Academic Medicine, 48, 630-635.

Nuhfer, E., Cogan, C., Fleisher, S. , Gaze, E. & Wirth, K. (2016). Random Number Simulations Reveal How Random Noise Affects the Measurements and Graphical Portrayals of Self-Assessed Competency. Numeracy, 9 (1), Art.4. http://dx.doi.org/10.5038/1936-4660.9.1.4

Peer, E., & Babad, E. (2014). The Doctor Fox Research (1973) Rerevisited: “Educational Seduction” Ruled Out. Journal of Educational Psychology, 106(1), 36–45. https://doi.org/10.1037/a0033827

Rowland, C. A. (2014). The Effect of Testing Versus Restudy on Retention: A Meta-analytic Review of the Testing Effect. Psychological Bulletin, 140(6), 1432–1463. https://doi.org/10.1037/a0037559

Rummer, R., & Schweppe, J. (2022). Komplexität und der Testungseffekt: Die mögliche Bedeutung der Verständnissicherung für den Nutzen von Abrufübung bei komplexem Lernmaterial. Unterrichtswissenschaft, 50, 37–52. https://doi.org/10.1007/s42010-021-00137-4

Ware, J. E. & Williams, R. (1975). The Dr. Fox Effect: A Study of Lecturer Effectiveness and Ratings of Instruction. Journal of Medical Education, 50(2), 149-156. https://doi.org/10.1097/00001888-197502000-00006

Yang, C., Luo, L., Vadillo, M. A., Yu, R., & Shanks, D. R. (2021). Testing (quizzing) boosts classroom learning: A systematic and meta-analytic review. Psychological Bulletin, 147(5), 399–433. https://doi.org/10.1037/bul0000309

Vorschlag zur Zitation

Hawelka, B., Bachmaier, R., Puppe, L. & Rottmeier, S. (2025, 11. Dezember). Mythos oder Mehrwert? Vier Lehr-Lern-Effekte im Faktencheck. Lehrblick – ZHW Uni Regensburg. https://doi.org/10.5283/ZHW.20251211.DE

Birgit Hawelka

Dr. Birgit Hawelka ist wissenschaftliche Mitarbeiterin am Zentrum für Hochschul- und Wissenschaftsdidaktik an der Universität Regensburg. In Forschung und Lehre beschäftigt sie sich schwerpunktmäßig mit den Themenfeldern Lehrqualität und Evaluation. Ansonsten verfolgt sie neugierig alle Entwicklungen und Erkenntnisse rund um das Thema Hochschullehre.

-

Birgit Hawelka

-

Birgit Hawelka

Regine Bachmaier

Dr. Regine Bachmaier ist wissenschaftliche Mitarbeiterin am Zentrum für Hochschul- und Wissenschaftsdidaktik der Universität Regensburg. Sie unterstützt die Lehrenden im Bereich "Digitale Lehre", u.a. durch Workshops sowie individuelle Beratung. Daneben versucht sie, den Überblick über Aktuelles aus dem Bereich "Digitale Lehre" zu behalten und weiterzugeben.

-

Regine Bachmaier

-

Regine Bachmaier

Linda Puppe

Dr. Linda Puppe ist wissenschaftliche Mitarbeiterin am Zentrum für Hochschul- und Wissenschaftsdidaktik an der Universität Regensburg. Sie beschäftigt sich schwerpunktmäßig mit den Themenfeldern innovative Lehre und Motivation. Zudem interessiert sie sich für Entwicklungen im Bereich digitale Lernumgebungen.

Stephanie Rottmeier

Dr. Stephanie Rottmeier ist wissenschaftliche Mitarbeiterin am Zentrum für Hochschul- und Wissenschaftsdidaktik (ZHW) der Universität Regensburg. Sie unterstützt und berät Dozenten bei der didaktischen Gestaltung von Vorlesungen und Seminaren. Ihr Schwerpunkt liegt dabei auf den Themen selbstreguliertes Lernen, insbesondere der digitalen Organisation von Selbstlernphasen, und Lernmotivation von Studierenden.

-

Stephanie Rottmeier

-

Stephanie Rottmeier

-

Stephanie Rottmeier