Worin liegen die Stärken meiner Lehrveranstaltung? Was könnte ich tun, um die Lernprozesse meiner Studierenden besser zu unterstützen? Eine qualitative Evaluation von Lehrveranstaltungen mit TAP gibt Antworten auf diese Fragen und erlaubt damit Einblicke in die Lernprozesse von Studierenden. Eine gute Grundlage, um datenbasiert Lehrveranstaltungen weiter zu entwickeln.

Die Vermessung der Lehre: Eine kritische Bestandsaufnahme

Evaluation von Lehrveranstaltungen ist an Hochschulen inzwischen fester Bestandteil der Qualitätssicherung von Lehre. In der Regel werden dazu die Studierenden am Ende eines Semesters gebeten, mit Hilfe von standardisierten Fragebögen die Lehrveranstaltung zu bewerten. Dieses Vorgehen ist zweifelsohne praktikabel, da damit rasch eine Vielzahl an Veranstaltungen mit beliebiger Teilnehmerzahl evaluiert werden kann. Allerdings werden einige Mängel seit Längerem kritisiert:

Bei Lehre gibt es kein “one size fits all”: Lehrveranstaltungen sind in der Zusammensetzung ihrer Studierenden, der Durchführung und Zielsetzung sehr heterogen. Entsprechend kann die Festlegung von Evaluationskriterien (als Merkmale erfolgreichen didaktischen Handelns) nur vor dem Hintergrund des spezifischen Kontextes erfolgen (Renkl, 2015). Bei einer klassischen Vorlesung bspw. ist eine klare, strukturierte Darstellung von Inhalten ein zentrales Qualitätsmerkmal. In einem geisteswissenschaftlichen Seminar hingegen ist es wesentlicher, dass die Studierenden durch eine geschickte Moderation angeregt werden, Inhalte kritisch zu prüfen und zu diskutieren. Individuelles Feedback wiederum ist dann zentral, wenn die Studierenden z.B. statistische Aufgaben lösen. Eine Analyse von verschiedenen Evaluationsbögen deutscher Universitäten und Hochschulen zeigte jedoch, dass individuelle Lernbedingungen in den standardisierten Bögen kaum erfasst werden (Barzon & Jahnke, 2010).

Problematisch ist auch, dass Lehrende aus den Rückmeldungen kaum Hinweise zur Verbesserung ihrer Lehre ziehen können. Ein Item wie “der Dozent / die Dozentin kann Kompliziertes verständlich machen” erhebt sicherlich, in welchem Ausmaß die Vermittlung gelungen ist. Im Falle einer kritischen Bewertung ist es allerdings für Lehrende in der Regel schwierig, konkrete Handlungsvorschläge für eine bessere Verständlichkeit zu ziehen (Barzon & Jahnke, 2010). Sollten ich mehr Beispiele verwenden? Ist meine Vorgehensweise zu schnell? Fehlt ein roter Faden? Oder haben die Studierenden nicht die nötigen Vorkenntnisse? Fragen wie diese können aus dem rein quantitativen Feedback nicht beantwortet werden.

Es ist daher hilfreich, eine quantitative Evaluation mit qualitativen Methoden zu ergänzen. Denn während quantitative Erhebungen vorwiegend numerische Messwerte liefern (z.B. einen Mittelwert), ermöglichen qualitative Methoden durch die offene Fragestellung eine stärker interpretative Auswertung. Das Zentrum für Hochschul- und Wissenschaftsdidaktik (ZHW) der Universität Regensburg bietet daher bereits seit über 10 Jahren eine Teaching Analysis Poll als Ergänzung zu den üblichen Erhebungen mit Fragebögen an.

Stärken und Schwächen in Kleingruppen diskutieren

Teaching Analysis Poll (TAP) wird üblicherweise in der Mitte eines Semesters durchgeführt und läuft nach einem einfachen Schema ab: Studierende diskutieren in einem moderierten Gruppengespräch, was in einer Lehrveranstaltung ihren Lernprozess unterstützt und was sie als hinderlich erleben. Die Rückmeldungen werden durch ein:e hochschuldidaktische/n Moderator:in analysiert und unter didaktischen Gesichtspunkten geordnet. In einem abschließenden Beratungsgespräch erarbeiten Lehrende gemeinsam mit einer Hochschuldidaktiker:in Möglichkeiten zur Fortentwicklung ihrer Lehrveranstaltung. Und so funktioniert ein TAP an der Universität Regensburg:

Rückmeldungen didaktisch analysieren

Die skizzierte Methodik von ‚Teaching Analysis Poll‘ weist im Vergleich zu anderen Evaluationsansätzen einige wesentliche methodische Vorzüge auf (vgl. dazu Hawelka & Hiltmann, 2018). Aus pädagogischer Sicht wesentlich ist dabei die didaktische Analyse der studentischen Rückmeldungen.

Wie das Video zeigt, halten die Studierenden ihre Ergebnisse in Stichpunkten schriftlich fest. Im Plenum werden die genannten Punkte nochmals durch den/die Moderator:in paraphrasiert und widergespiegelt. Dabei werden mehrdeutige und missverständliche Aussagen geklärt und didaktisch interpretiert. Beispielhaft lässt sich dieses Vorgehen durch die Aussage „NUR Referate“ verdeutlichen. Diese Aussage lässt zunächst unterschiedliche Deutungsmuster zu: (1) Die Studierenden könnten den Ablauf der Sitzungen als monoton empfinden, weil als didaktische Methode ausschließlich studentische Referate eingesetzt werden. (2) Oder aber sie vermissen Input durch die Lehrperson und bewerten den Input durch Kommilitonen als zu umfangreich.

In diesem Beispiel wurde durch Nachfragen des Moderators deutlich, dass die Studierenden es als hinderlich für ihren Lernprozess empfinden, dass die Lehrperson zu wenig Input gibt. Die ursprüngliche Rückmeldung „Nur Referate“ wurde in diesem Beispiel mit „zu wenig Input durch Dozenten“ paraphrasiert.

Die paraphrasierten Antworten werden mit Hilfe eines Kodierleitfadens (Hawelka, 2017) nach didaktischen Kriterien geordnet und vor dem Hintergrund der angestrebten Lernziele interpretiert. Als Ergebnis erhalten die Lehrenden eine strukturierte Rückmeldung.

Lehrveranstaltungen zielführend entwickeln

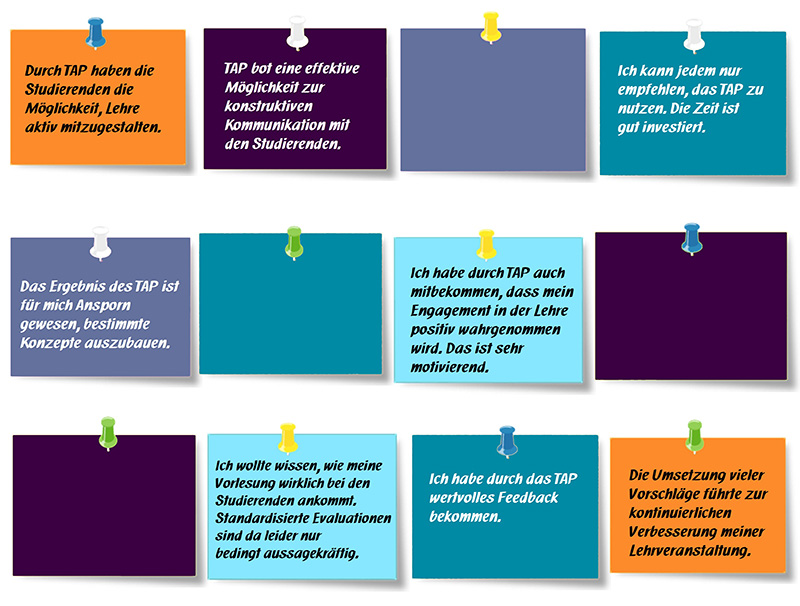

Diese Rückmeldung dient als Grundlage für ein Beratungsgespräch über mögliche Änderungen und Verbesserungen der Lehrveranstaltung. Die Evaluation bildet somit die Basis für eine datenbasierte Lehrberatung. Die Effektivität dieser Kombination von Evaluation und Beratung ist empirisch gut belegt (Penny & Coe, 2004). Auch die persönlichen Erfahrungen von Lehrenden an der Universität Regensburg verdeutlichen: Mit Hilfe eines TAP können nicht nur Stärken und Schwächen einer Lehrveranstaltung aufgedeckt, sondern auch direkt hilfreiche Ansätze zur Fortentwicklung von Veranstaltungen entwickelt werden. Abbildung 1 zeigt, wie Lehrende der Universität Regensburg den Nutzen der Methodik einschätzen.

Lehrende der Universität Regensburg können sich zur Mitte jedes Semesters über die Webseite des ZHW für ein TAP anmelden. Außerdem tauschen wir uns natürlich gerne über Erfahrungen und Vorgehensweisen zu TAP aus. Bitte nutzen Sie dazu auch unsere Kommentarfunktion.

Literatur

Burzan, N. & Jahnke, I. (2010). Was misst die studentische Lehrkritik? Eine empirische Infragestellung von Lehrevaluationen an Hochschulen. Soziologie, 39(4), 438-461.

Hawelka, B. (2017). Handreichung zur Kodierung qualitativer Evaluationsdaten aus Teaching Analysis Poll. Schriftenreihe (ZHW) 5, überarbeitete Version vom März 2017, Zentrum für Hochschul- und Wissenschaftsdidaktik, Regensburg.

Hawelka, B. & Hiltmann, S. (2018). Teaching Analysis Poll – ein Kodierleitfaden zur Analyse qualitativer Evaluationsdaten. In M. Schmohr & K. Müller (Hrsg.), Gelingende Lehre: erkennen, entwickeln, etablieren (S. 73-92). Bielefeld: Bertelsmann.

Penny, A. & Coe, R. (2004). Effectiveness of Consultation on Student Ratings Feedback: A Meta-Analysis. Review of Educational Research, 74(2), 215–253.

Renkl, A. (2015). Drei Dogmen guten Lernens und Lehrens: Warum Sie falsch sind. Psychologische Rundschau, 66(4), 211-220.

Vorschlag zur Zitation des Blogbeitrags

Hawelka, B. (2021, 18. November). Teaching Analysis Poll (TAP) – mehr als qualitative Evaluation. Lehrblick – ZHW Uni Regensburg. https://doi.org/10.5283/ZHW.20211118.DE

Birgit Hawelka

Dr. Birgit Hawelka ist wissenschaftliche Mitarbeiterin am Zentrum für Hochschul- und Wissenschaftsdidaktik an der Universität Regensburg. In Forschung und Lehre beschäftigt sie sich schwerpunktmäßig mit den Themenfeldern Lehrqualität und Evaluation. Ansonsten verfolgt sie neugierig alle Entwicklungen und Erkenntnisse rund um das Thema Hochschullehre.

- Birgit Hawelka

- Birgit Hawelka